El robots.txt es un archivo de texto que se instala en el sitio web, específicamente en la raíz del dominio. Principalmente, es utilizado para impedir que los robots de ciertos buscadores rastreen contenido que no deseamos que indexen, ni muestren en sus resultados.

Este archivo de texto no es un mecanismo para mantener una página web fuera de Google, ya que para esto sirven las etiquetas con las directivas index o noindex. Este tipo archivo es principalmente utilizado para gestionar el tráfico de los robots rastreadores a tu sitio web.

De esta manera, si existen ciertos archivos multimedia como imágenes, vídeos y páginas dentro de un sitio web, se puede habilitar o deshabilitar el la lectura y acceso de cualquier robot de los buscadores.

¿Para qué nos sirve el archivo robots.txt?

Para que ciertas página o directorios del sitio web no sean accesibles a los buscadores.

Para bloquear el acceso de los robots a ciertos archivos o carpetas del sitio web.

Para indicarle al robot la ubicación del sitemap o mapa del sitio.

3 limitaciones del archivo robots.txt

- Las instrucciones de robots.txt son solo indicaciones, ya que, si se quiere bloquear o restringir el acceso a determinado sitio web, hay que emplear otras técnicas.

- Los distintos robots rastreadores interpretan la sintaxis de varias formas, y estas hay que conocerlas para poder dirigirnos a los distintos robots según sus propios códigos.

- Las páginas bloqueadas mediante un archivo robots.txt todavía pueden indexarse si hay enlaces a ellas en otros sitios web, para esto hay que proteger con contraseña los archivos en el servidor.

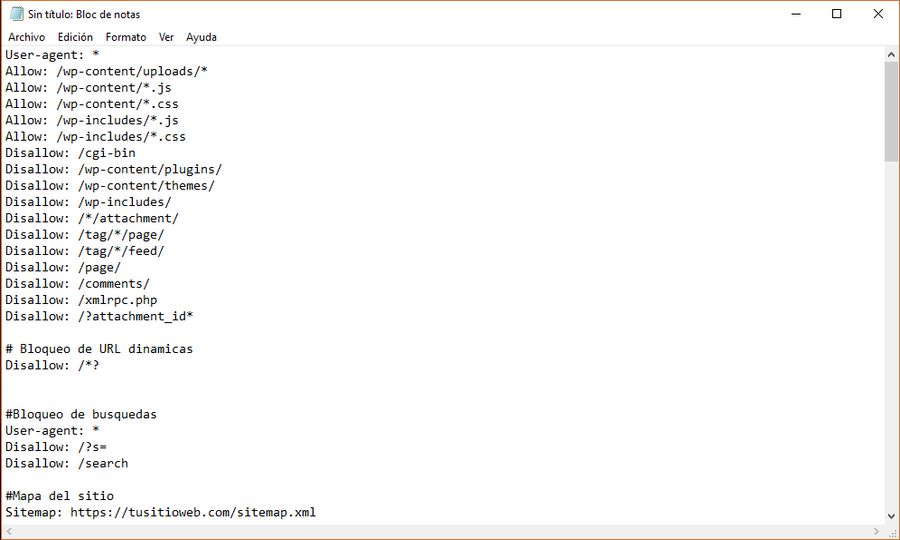

Para poder crearlo, necesitamos acceso a la raíz del dominio y subir el archivo en formato texto con nombre “robots.txt”, al directorio raíz de primer nivel del servidor de nuestra web.

Principales comandos del robots.txt

- User-agent: o agente de usuario, son los robots o arañas de los motores de búsqueda. En este enlace encontrarás una lista con la mayoría de robots rastreadores que conocemos en internet.

Su sintaxis sería:

User-agent: [nombre del robot al que aplicaremos la regla]

- Disallow: indica al agente de usuario o user agent que no debe acceder, rastrear ni indexar una URL, subdirectorio o directorio concreto.

Disallow: [directorio que quieres bloquear]

- Allow: surge como contra al anterior, con él indicas al rastreador una URL, subdirectorio o directorio al que si queremos que se entre, rastree o indexe.

Allow: [URL de un directorio o subdirectorio bloqueado que quieres desbloquear]

Cuando se especifica la regla allow o disallow solo se aplican a los agentes de usuarios que previamente se han mencionado en el inicio del archivo. Se puede incluir en diferentes líneas varios allow o disallow a diferentes url o carpetas del sitio web.

¿Cómo instalar y probar un robots.txt?

La creación del archivo robots.txt es muy fácil. Para instalarlo hay que darle acceso al archivo en la raíz del dominio y subir el archivo en formato texto con el nombre “robots.txt” al directorio de la raíz de primer nivel de nuestro servidor.

Una vez que tengas el archivo de texto listo, antes de subirlo, puedes ir a la herramienta de Google Search Console y en el apartado de Googlebot se leerá el archivo y te informarán de los posibles errores que pueda tener.

Siempre debemos tener claro que el archivo robots.txt es de acceso público, es decir, cualquier persona que tenga acceso a internet podría verlo.

Si quisiéramos bloquear acceso a cierto contenido de nuestro sitio web, no deberíamos utilizar este archivo como herramienta, sino proteger con contraseña en el servidor aquellas páginas que no queremos sean de conocimiento público.

Si quieres conocer más técnicas de posicionamiento SEO, SEM, analytics, gestión de páginas en WordPress, te recomendamos que realices un Máster presencial en Marketing Digital, para que así te formes y capacites más para el mercado digital que cada día crece y evoluciona más.